Dieser Blogpost zeigt, wie du mit AWS S3 Glacier Deep Archive kostengünstig und zuverlässig Backups von wichtigen Medien wie Fotos und Videos durchführen kannst. Anhand meiner eigenen 3-2-1 Backup-Strategie erfährst du, wie du Daten lokal auf einem NAS und einer zusätzlichen TrueNAS-Box sicherst und sie anschließend verschlüsselt und komprimiert in die AWS-Cloud überträgst. Du erhältst außerdem ein Shellscript für automatisierte Uploads zu S3 Glacier Deep Archive sowie wichtige Hinweise zur sicheren Verwaltung von Passwörtern und Schlüsseln.

Warum AWS S3 Glacier Deep Archive?

AWS S3 Glacier Deep Archive ist eine ideale Lösung für langfristige Offsite-Backups, insbesondere wenn du die gespeicherten Daten im Normalfall nie abrufst. Die Daten werden in Rechenzentren verschlüsselt gespeichert. AWS garantiert die Verfügbarkeit. Die Vorteile auf einen Blick:

- Räumliche Trennung: Die Daten sind physisch weit entfernt, was deine Sicherung vor lokalen Katastrophen schützt.

- Redundanz & Wartung: AWS übernimmt regelmäßige Überprüfung und Wartung der Speichermedien.

- Günstiger Preis: In EU-north zahlst du nur $0,00099 pro GB monatlich – das entspricht etwa $1 pro Terabyte und Monat.

Einziger Nachteil: Die Wiederherstellung dauert etwa 12 Stunden und kostet rund $0,02 pro GB ($20 pro Terabyte). Da diese Backups jedoch nur im absoluten Notfall benötigt werden, ist das akzeptabel.

Ich verwende eu-north, weil dort im vergleich zu anderen Regionen der CO2 Fußabdruck, durch die stärkere Nutzung erneuerbarer Energien, geringer ist.

Die 3-2-1 Backup-Strategie

Ich nutze die bewährte 3-2-1 Backup-Strategie, um meine Medien sicher zu speichern:

- 3 Kopien: Originaldaten auf Smartphones, Sicherung auf einer Synology NAS und weitere Sicherung auf einer TrueNAS-Box. In meinem Fall durch die Nutzung von S3 sind es sogar 4 Kopien.

- 2 unterschiedliche Medien: Die Synology NAS sowie TrueNAS Box verwenden Festplatten als Backup-Medium. S3 verwendet Magnet-Bänder.

- 1 Offsite-Kopie: Komprimierte und verschlüsselte Daten werden halbjährlich auf AWS S3 Glacier Deep Archive hochgeladen.

Diese Staffelung und Trennung erhöht die Sicherheit für eure Daten. Fallen Festplatten aus – etwa durch einen Blitzschlag, gibt es eine Offsite-Sicherung oder ein anderes Medium. Hätte z.b. das Synology NAS einen fatalen Software Fehler nach einem Update, habe ich noch die TrueNAS.

Meine Backup-Infrastruktur im Detail

Lokale Sicherung mit Synology NAS und TrueNAS

Alle Smartphones sichern automatisch ihre Medien via Synology Photos auf meine Synology NAS, die mit einem SHR-RAID-Setup (eine von vier Platten kann ausfallen) die Daten zuverlässig speichert. Zusätzlich speichert die NAS übrigens auch regelmäßige Backups der PCs und meine Homelab-Server.

Einmal monatlich werden die relevanten Daten, vor allem Medien, auf eine TrueNAS-Scale Box im Haus übertragen, die ausschließlich zu diesem Zweck mit Netzwerk und Strom verbunden wird und ansonsten offline bleibt. Dies ist ein älterer nicht mehr Energie-Effizienter PC mit einem ganzen Stapel älterer Festplatten, die per ZFS nochmals die Ausfallsicherheit verbessern.

Offsite-Sicherung mit AWS S3 Glacier Deep Archive

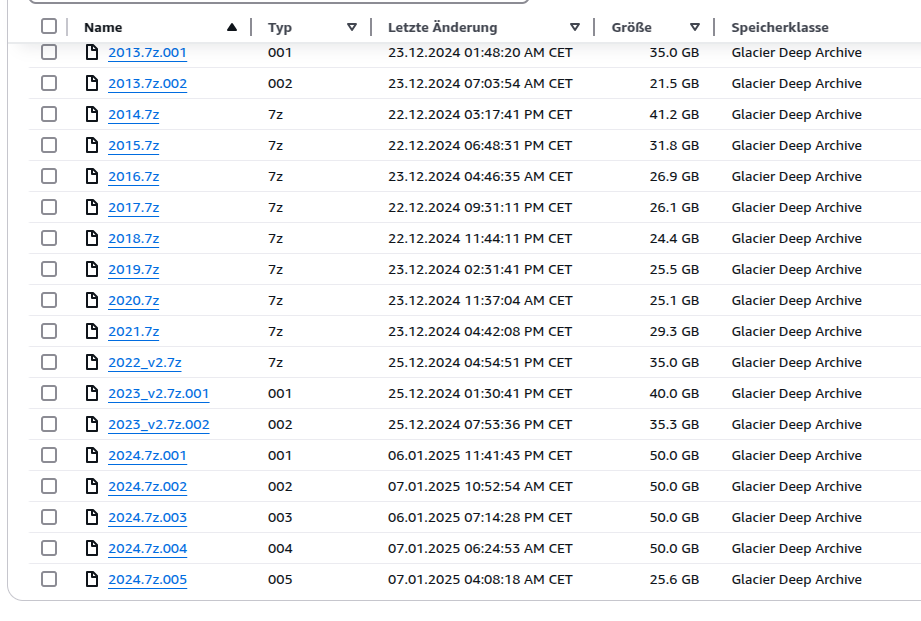

Etwa alle sechs Monate erstelle ich ein mit 7zip komprimiertes und AES-256 verschlüsseltes Archiv meiner Daten und lade dieses in meinen AWS S3 Bucket hoch. Ich nutze aktuell knapp 1TB Speicherplatz für Fotos und Videos aus über 20 Jahren Digitalfotografie.

In den letzten Jahren ist der Speicherbedarf hierfür durch höhere Auflösungen und insbesondere Videos von Smartphones und Actioncam explodiert.

Wie hier zu sehen ist, teile ich größere Archive in Blöcke von 35 bis 50Gb auf – das ist aber nicht zwingend nötig. Kamen wie bei 2022/23 noch Medien verspätet dazu, lade ich eine „v2“ hoch und lasse die vorherigen Dateien löschen.

AWS CLI installieren und konfigurieren

Für die Nutzung des Shellscripts ist zunächst die Installation und Konfiguration der AWS CLI notwendig. Eine detaillierte Anleitung findest du hier: AWS CLI installieren

Danach konfigurierst du die CLI mit deinem AWS Access Key und Secret Access Key, die du in AWS IAM erstellen kannst:

aws configure

Shellscript zum Upload

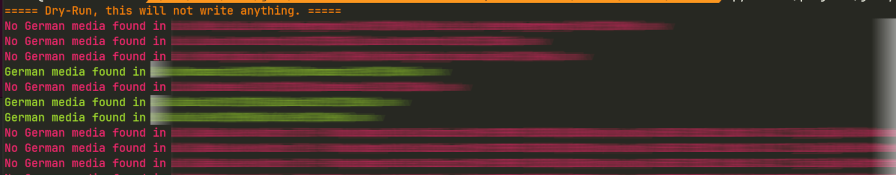

Hier ist das einfache Shellscript, das ich verwende, um die Archive automatisch in AWS S3 Glacier Deep Archive zu laden:

#!/bin/bash

# Specify the S3 bucket name

BUCKET_NAME="s3-backup-privat"

# Find all files matching the patterns *.7z or *.7z.* in the current directory

for file in $(find ./s3 -maxdepth 1 -type f \( -name "*.7z" -o -name "*.7z.*" \)); do

# Remove leading './' from the file path

file_basename=$(basename "$file")

# Print the filename

echo "Uploading: $file_basename"

# Upload the file to the S3 bucket

aws s3 cp "$file" "s3://$BUCKET_NAME/$file_basename" --storage-class DEEP_ARCHIVE

done

Das script findet alle 7z Dateien in im Ordner S3 und schickt sie in mein „s3-backup-privat“ bucket.

Ein Lifecycle-Management ist nicht nötig, da die Storage-Klasse direkt per CLI gesetzt wird.

Statt des Scriptes wäre ein Upload via WebUI auch möglich, jedoch bei großen Dateien fehleranfälliger.

Sicherheitshinweis: Passwort- und Schlüsselverwaltung

Teil deiner Backup-Strategie sollte immer auch die sichere Verwaltung deiner Passwörter, AWS-Zugangsschlüssel und Verschlüsselungspasswörter sein. Stelle sicher, dass diese Daten separat und sicher gespeichert sind, damit sie im Katastrophenfall (z. B. Verlust der Hardware) zur Verfügung stehen.

Ich verwende hierfür KeePass und synchronisiere die zugehörige Datei zwischen allen Geräten und nochmals in eine Hetzer Storageshare Instanz. Hier habe ich gewissermaßen noch einen offenen Punkt, denn sollten mir wirklich PC, Notebook, Smartphone und Tablet abhanden kommen (Einbruch, Feuer), käme ich mangels Zugangsdaten auch nicht mehr an meine KeePass Datei heran.

Mein Passwort für die Sicherung in 7zip ist eine zufällige, wirklich lange Zeichenfolge, die ich von KeePass habe generieren lassen und auch darin speichere. Für den Fall, dass dich irgendjemand irgendwie an die S3 Dateien heran kommt will ich verhindern, dass die Archive leicht entpackt werden können. die 7Z AES-256 Verschlüsselung sollte dafür ausreichend sein.

Kostenmanagement

AWS wird die auflaufenden Kosten monatlich von deiner Kreditkarte abbuchen. Falls du automatische Sicherungen einrichtest und uU vergessen könntest was da alles gesichert wird, solltest du unbedingt Budget-Warnungen einrichten um Überraschungen zu vermeiden.

Alternativen zur Cloud-Sicherung

Wenn Cloud-Speicherung für dich nicht infrage kommt, kannst du alternativ deine Archive auf externen Festplatten oder ähnlichen Medien sichern und diese bei Freunden, Familie oder in einem Bankschließfach lagern. Auch dies bietet eine räumliche Trennung und schützt deine Daten im Katastrophenfall. Das Auffrischen der Sicherungen macht in dem Fall etwas mehr Arbeit: Sichern auf 2. Festplatte, zu Oma fahren, dort die Platte gegen die eingelagerte tauschen, diese dann wieder zuhause prüfen und Daten wieder sichern….

Fazit

AWS S3 Glacier Deep Archive ist eine hervorragende, kostengünstige Lösung für zuverlässige Offsite-Backups deiner wichtigsten Daten. In Kombination mit einer guten lokalen Sicherungsstrategie erreichst du maximale Sicherheit für deine wertvollen Erinnerungen und Daten.